L’ultimo modello di intelligenza artificiale dell’azienda promette capacità di ragionamento potenziate e prestazioni senza precedenti, sollevando al contempo nuovi interrogativi sulla sicurezza e sull’intelligenza artificiale generale.

OpenAI ha presentato o3, il successore del modello “di ragionamento” o1, nell’ambito dell’evento “shipmas”. Questa nuova versione è in realtà una famiglia di modelli composta da o3 e o3-mini. L’azienda ha saltato il nome “o2” a causa di potenziali conflitti di marchio con la società di telecomunicazioni britannica O2.

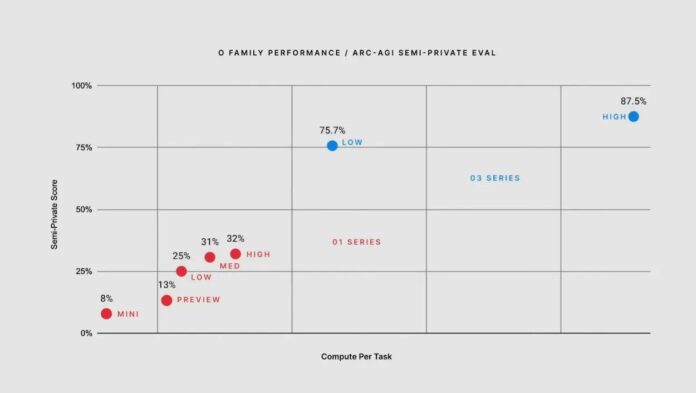

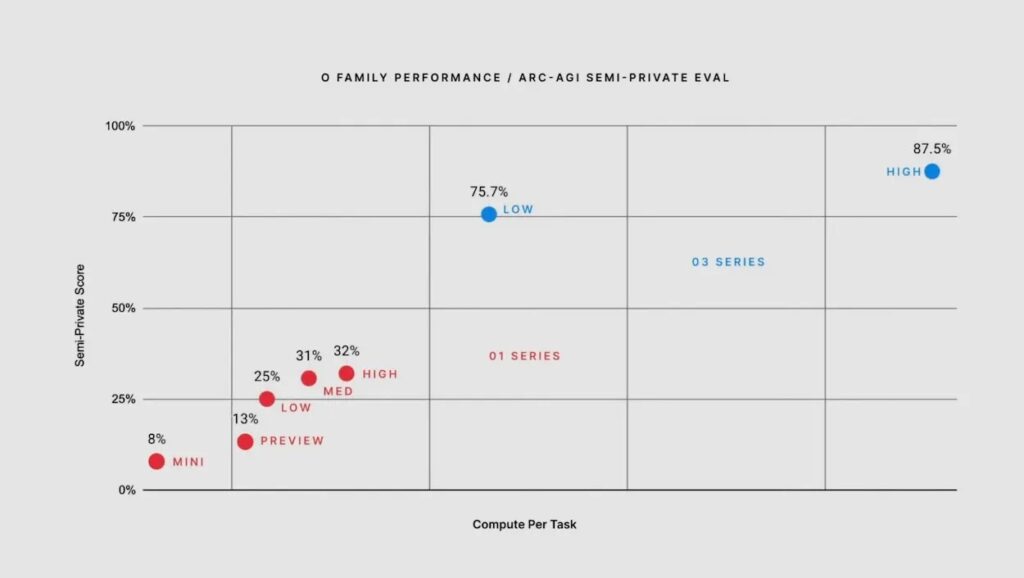

Il modello impiega un “allineamento deliberativo” per la sicurezza e si avvale di un sistema unico di autocontrollo attraverso una “catena di pensiero privata”. Sebbene richieda più tempo per rispondere (da secondi a minuti), mira a essere più affidabile. Una novità degna di nota è la possibilità di regolare il “tempo di ragionamento” con impostazioni di calcolo basse, medie o alte, dove le impostazioni di calcolo più elevate offrono prestazioni migliori ma a un costo significativo.

Il precedente modello o1 ha dimostrato percentuali di inganno più elevate rispetto ai modelli di intelligenza artificiale convenzionali di concorrenti come Meta, Anthropic e Google. Si teme che il modello o3 possa presentare livelli di inganno ancora più elevati, anche se si attendono ancora i risultati dei test di sicurezza condotti dai partner.

Come riportato qui, o3 ha mostrato risultati impressionanti in vari benchmark, eccellendo in particolare in matematica, programmazione e ragionamento scientifico, sebbene questi risultati si basino su valutazioni interne.

L’allineamento deliberativo di OpenAI rappresenta un progresso significativo nel campo dell’allenamento sulla sicurezza dell’intelligenza artificiale. Questo approccio insegna direttamente ai modelli le specifiche di sicurezza in linguaggio naturale, anziché richiedere loro di dedurre il comportamento da esempi. Questo processo combina la messa a punto supervisionata con l’apprendimento per rinforzo, consentendo al modello di generare automaticamente dati di addestramento senza una classificazione umana. Il sistema inizia con un modello di tipo ‘o’ addestrato per garantire affidabilità, quindi costruisce insiemi di dati in cui i completamenti della Catena del Pensiero (CoT) fanno riferimento a specifiche specifiche di sicurezza. Attraverso questo processo, il modello sviluppa una comprensione dei protocolli di sicurezza e la capacità di ragionare su di essi in modo efficace.

La convalida più eclatante delle capacità di o3 proviene dai test ARC AGI, in cui il modello ha ottenuto un punteggio senza precedenti dell’85,7% su parametri di calcolo elevati. Questo punteggio è particolarmente significativo perché supera la soglia di performance umana dell’85%, una novità assoluta nel campo dei test di intelligenza artificiale. Questi test di riconoscimento dei pattern basati sui pixel, progettati per valutare le competenze logiche, dimostrano la capacità di o3 di eguagliare e potenzialmente superare le prestazioni umane in alcuni compiti di ragionamento.

OpenAI suggerisce che l’o3 si avvicini all’AGI (intelligenza artificiale generale) in determinate condizioni. Tuttavia, esperti esterni come François Chollet contestano questa affermazione, sottolineando che il modello ha ancora difficoltà con “compiti molto facili”. Chollet sottolinea che una vera AGI renderebbe impossibile creare compiti facili per gli esseri umani ma difficili per l’IA. Secondo i termini di partnership di OpenAI con Microsoft, il raggiungimento dell’AGI li solleverebbe dall’obbligo di condividere le loro tecnologie più avanzate con Microsoft.

La creazione e lo sviluppo di o3 arrivano anche in un momento importante per OpenAI, poiché uno dei suoi scienziati più validi, Alec Radford, che ha guidato lo sviluppo della serie GPT, ha annunciato la sua rinuncia per dedicarsi a ricerche indipendenti.

Mentre OpenAI svela la complessità tecnica dell’allineamento deliberativo di o3 e dimostra prestazioni senza precedenti su benchmark chiave come ARC AGI, il modello rappresenta più di un semplice progresso incrementale nello sviluppo dell’IA. Sebbene le preoccupazioni per la sicurezza persistano, la capacità di o3 di eguagliare e superare le prestazioni umane su specifici compiti di ragionamento, unita al suo nuovo approccio alla formazione sulla sicurezza, suggerisce un significativo balzo in avanti nelle capacità dell’IA. Con l’o3, la questione potrebbe non essere più se ci stiamo avvicinando all’ Intelligenza Artificiale Generale, ma piuttosto come gestirne responsabilmente l’emergere.